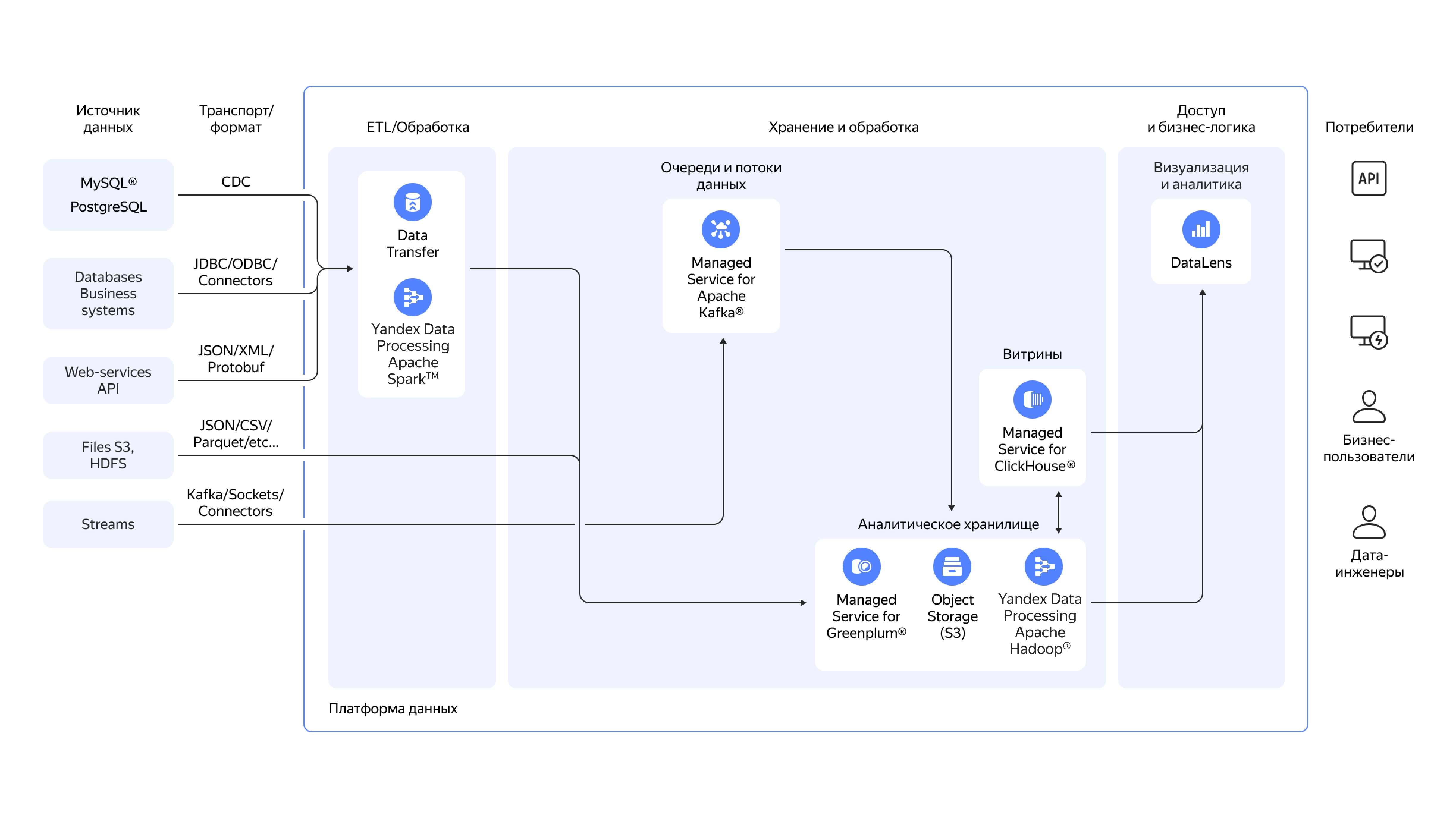

Архитектура корпоративного хранилища данных построена по принципу многоуровневой обработки и интеграции данных из разнородных источников. На входе системы находятся различные источники: транзакционные базы данных MySQL® и PostgreSQL с поддержкой CDC (Change Data Capture, захват изменений данных), корпоративные системы через JDBC/ODBC‑коннекторы, веб‑сервисы через API с форматами JSON/XML/Protobuf, файловые хранилища Object Storage и HDFS с данными в форматах JSON/CSV/Parquet, а также потоковые источники через Kafka® и Sockets. Данные проходят через слой ETL‑обработки, где Yandex Data Transfer обеспечивает репликацию и миграцию, а Yandex Data Processing на базе Apache Spark™ выполняет трансформацию и обогащение. Очереди и потоки данных, управляемые через Yandex Managed Service for Apache Kafka®, обеспечивают надёжную доставку и буферизацию. Центральное аналитическое хранилище формируется на базе трёх компонентов: Yandex Managed Service for Greenplum® как основная MPP‑система для структурированных данных, Object Storage — для хранения сырых данных и файлов, Yandex Data Processing (Apache Hadoop®) — для обработки больших объёмов неструктурированных данных. Витрины данных создаются в Yandex Managed Service for ClickHouse® для обеспечения быстрого доступа к предагрегированным данным. На верхнем уровне архитектуры находятся инструменты доступа: DataLens для визуализации и аналитики, API для программного взаимодействия, интерфейсы для бизнес‑пользователей и дата‑инженеров, обеспечивающие работу с данными в соответствии с их ролями и задачами.

Как Data Warehouse помогает бизнесу экономить деньги и принимать решения

Data Warehouse (DWH) — это не просто хранилище. Это мозговой центр компании, где исторические данные превращаются в стратегические инсайты. Рассказываем, как работает DWH и почему он нужен бизнесу.

- DWH (Data Warehouse) объединяет данные из разных систем компании, очищает их от ошибок и противоречий, структурирует для быстрого анализа.

- DWH отличается от транзакционных баз данных (OLTP) подходом к обработке информации: OLTP оптимизированы для быстрой записи и изменения, а DWH — для интеграции и историзации на уровне всей компании.

- У архитектуры DWH несколько уровней: источники данных, ETL-процессы, ядро хранилища, витрины данных, сервисный уровень, уровень доступа и аналитики.

- У моделирования данных в DWH есть несколько типовых схем: «звезда», «снежинка», «галактика» (созвездие фактов).

- Проектирование DWH состоит из сбора требований, проектирования концепции и модели данных, выбора платформы и архитектуры, реализации и загрузки данных, тестирования и валидации, внедрения и запуска.

- Операционное управление DWH состоит из мониторинга и поддержки, версионирования изменений, управления метаданными, безопасности и управления доступом.

- При внедрении DWH могут возникнуть проблемы: миграция из легаси-систем, несогласованность метрик и данных, высокая стоимость владения, низкое качество исходных данных.

- Yandex Cloud предлагает инструменты для построения DWH и других архитектур хранения данных, включая Greenplum®, ClickHouse®, Spark™, Hadoop® и Lakehouse.

- Для анализа и визуализации данных можно использовать платформу YTsaurus и сервис бизнес-аналитики Yandex DataLens.

Data Warehouse, или корпоративное хранилище данных (КХД), собирает данные из всех систем компании за годы работы. CRM знает о клиентах, ERP — о финансах, логистические системы — о поставках. Но каждая система видит только свой фрагмент. DWH объединяет эти фрагменты в единую картину, очищает от ошибок и противоречий, структурирует для быстрого анализа.

Благодаря хранилищу руководители видят бизнес целиком — от первой продажи до последней поставки. На основе этих данных строятся прогнозы, выявляются тренды, принимаются стратегические решения. Системы бизнес‑аналитики визуализируют информацию из DWH, превращая массивы чисел в понятные графики и дашборды.

В статье расскажем, как устроено корпоративное хранилище данных, чем оно отличается от обычных баз, как его проектировать и внедрять. Покажем реальные сценарии использования в разных отраслях и объясним, какие проблемы может решить DWH. В конце разберём, как построить хранилище на нашей платформе и какие инструменты для этого понадобятся.

Сценарии использования DWH

Корпоративные хранилища данных применяются во всех отраслях, где нужно вести анализ на пересечении различных подразделений и бизнес‑процессов. Разберём конкретные примеры, как компании используют DWH для решения бизнес‑задач.

Ритейл

Сетевые магазины накапливают в DWH данные о продажах за несколько лет — что покупали, когда, где, по какой цене. К этому добавляется информация о покупателях из программ лояльности, данные о запасах на складах, погодные условия в день покупки. Анализ этого массива помогает точно прогнозировать спрос. Сеть супермаркетов может заранее увеличить поставки мороженого перед жаркими выходными или закупить больше десертов к праздникам. DWH также позволяет сегментировать покупателей — выделять группы со схожим поведением и формировать для них персональные предложения.

Ритейлер Hoff совместно с интегратором AERO построил масштабируемое хранилище данных на нашей платформе. Компания ускорила подготовку отчётов и углубила анализ продаж, что позволило быстрее реагировать на изменения спроса. Сеть ресторанов ROSTIC’S пошла ещё дальше — их платформа данных по принципу Lakehouse с Greenplum® в качестве основного хранилища и ClickHouse® для витрин данных ускорила обработку информации вдвое. Внедрение новых функций для анализа продаж теперь происходит втрое быстрее.

Финансы

Банки используют DWH для консолидации данных о миллионах транзакций, кредитных историях, поведении клиентов. На основе исторических паттернов строятся модели для выявления мошенничества — система замечает нетипичные операции и блокирует подозрительные транзакции. Хранилище также помогает оценивать кредитные риски: анализируя данные о тысячах выданных кредитов, банк понимает, какие факторы влияют на вероятность невозврата. Регуляторная отчётность тоже формируется из DWH — все необходимые данные уже собраны и проверены.

Финтех‑сервис «Мокка» построил хранилище и DWH в облаке, что привело к росту ROI с 300% до 450%. Благодаря единому хранилищу компания смогла точнее анализировать поведение клиентов, оптимизировать кредитные предложения и снизить риски невозврата.

Телеком

Операторы связи собирают в хранилище технические метрики сети, данные о звонках и трафике, информацию об абонентах и их тарифах. Анализ помогает находить проблемные участки сети — базовые станции с частыми сбоями или районы с недостаточной пропускной способностью. DWH позволяет прогнозировать отток клиентов: система выявляет признаки, что абонент собирается уйти к конкуренту, и компания может предложить ему специальные условия для удержания.

Дистрибуция и логистика

Компании‑дистрибьюторы сталкиваются с необходимостью объединять данные из десятков региональных систем учёта. Казахстанская компания AlmaWine, дистрибьютор алкогольной продукции, объединила в DWH информацию из 40 разрозненных учётных систем. Раньше сведение отчётов занимало несколько дней — теперь важнейшие данные обновляются ежечасно. Время подготовки аналитики сократилось до нескольких часов, а оборачиваемость запасов по отдельным товарам выросла на 30–40% благодаря более точному анализу спроса и остатков на складах.

Помимо этих отраслей, DWH активно применяют в промышленности для анализа работы оборудования и прогнозирования поломок, в онлайн‑сервисах — для изучения поведения пользователей. Теперь разберёмся, чем DWH отличается от обычных баз данных.

Отличия DWH от транзакционной базы данных

Data Warehouse и транзакционные базы данных решают разные задачи, хотя внешне могут выглядеть похоже. Главное отличие — в подходе к обработке информации.

Транзакционные системы относятся к классу OLTP — Online Transaction Processing. Они оптимизированы для быстрой записи и изменения данных. Когда клиент оплачивает покупку картой, транзакционная система мгновенно проверяет баланс, списывает деньги, обновляет остатки товара. Такие базы работают с актуальными данными здесь и сейчас. Такие базы данных лежат в основе CRM, ERP и систем учёта — всего, что поддерживает ежедневную работу компании.

DWH решает задачи интеграции и историзации данных на уровне всей компании. Интеграция — это приведение справочников к единой системе идентификаторов, когда один и тот же клиент в CRM и ERP получает единый код. Историзация отслеживает изменения атрибутов и значений во времени

В отличие от OLTP‑систем, которые работают с текущими транзакциями, DWH хранит исторические данные и оптимизирован под различные типы аналитических запросов. Если OLTP‑система ответит на вопрос «Сколько товара X осталось на складе?», то DWH поможет проанализировать продажи товара X по регионам за последние три года с учётом всех изменений цен и характеристик.

DWH поддерживает разные типы аналитических нагрузок: OLAP для многомерного анализа, регламентную отчётность, профилирование данных для исследования качества данных

Архитектурно системы тоже различаются. OLTP‑базы используют нормализованные структуры, чтобы исключить дублирование данных. В DWH применяется контролируемая денормализация — избыточность создаётся намеренно для ускорения аналитических запросов и упрощения построения отчётов. Одна и та же информация может храниться в разных форматах: в детальных таблицах фактов, агрегированных витринах, OLAP‑кубах.

Благодаря такому разделению компании получают лучшее из двух миров: операционные системы работают без задержек, а аналитики могут строить любые отчёты, не влияя на производительность основного бизнеса. Далее посмотрим, как устроена архитектура хранилища данных.

Extract, Transform, Load — извлечение, преобразование, загрузка.

Архитектура DWH

Корпоративное хранилище данных состоит из нескольких взаимосвязанных уровней, каждый из которых выполняет свою функцию.

Основные уровни и их функции в архитектуре корпоративного хранилища данных

|

Источники данных |

Сюда стекается информация из десятков систем: транзакции из банковских приложений, заказы из интернет‑магазинов, показатели с производственных датчиков, логи веб‑серверов. |

|

ETL‑процессы |

Обеспечивают движение данных от источников к хранилищу. На этапе извлечения система забирает данные из источников, стараясь минимально нагружать рабочие системы. Преобразование — самый сложный этап: данные очищаются от ошибок, приводятся к единому формату, обогащаются дополнительной информацией. На этапе загрузки готовые данные помещаются в хранилище. |

|

Ядро хранилища |

Здесь данные хранятся в структурированном виде, готовые к анализу. Современные DWH часто строятся на MPP‑системах вроде Greenplum®, которые распределяют данные и вычисления между множеством серверов. Это позволяет обрабатывать терабайты информации за приемлемое время. |

|

Витрины данных |

Специализированные подмножества данных для конкретных задач. Если всё хранилище — это склад, то витрины — это полки с товарами, подобранными для определённых покупателей. Маркетинг получает витрину с данными о клиентах и продажах, финансисты — с доходами и расходами, логисты — с информацией о поставках и т. д. Витрины строятся на быстрых аналитических СУБД типа ClickHouse. |

|

Сервисный уровень |

Обеспечивает бесперебойную работу всей системы. Мониторинг отслеживает производительность и доступность данных, система управления доступом контролирует, кто может видеть конфиденциальную информацию, аудит фиксирует все действия пользователей. |

|

Уровень доступа и аналитики |

Здесь бизнес‑пользователи работают с данными через привычные инструменты. BI‑системы вроде Yandex DataLens превращают сложные запросы в интерактивные дашборды. Аналитики строят отчёты без необходимости писать код. |

Такая многоуровневая архитектура обеспечивает гибкость и масштабируемость хранилища. Теперь разберёмся, как данные организованы внутри DWH.

Моделирование данных в DWH

Существует два основополагающих архитектурных подхода к построению хранилищ данных. Их предложили пионеры отрасли Билл Инмон и Ральф Кимбалл:

-

Архитектура Инмона предполагает создание корпоративного хранилища «сверху вниз». Сначала строится единое нормализованное хранилище с детальными интегрированными данными — каждый факт хранится только в одном месте, все справочники приведены к единой системе идентификаторов. Затем на основе этого ядра создаются специализированные витрины для отдельных подразделений, которые могут использовать любые модели данных, включая многомерные модели Кимбалла. Такой подход даёт целостную картину данных организации, но требует значительных первоначальных инвестиций в проектирование.

-

Архитектура Кимбалла работает «снизу вверх» через концепцию «шинной архитектуры». Витрины данных для конкретных бизнес‑процессов строятся напрямую из staging‑области, минуя централизованное детальное хранилище. Все витрины используют общие согласованные измерения — единые справочники товаров, клиентов, времени, которые обеспечивают интеграцию данных между витринами. Данные сразу организуются в денормализованные структуры, оптимизированные для аналитических запросов. Этот метод позволяет быстрее получить первые результаты и постепенно расширять охват бизнес‑процессов.

В основе обеих архитектур при проектировании витрин лежат понятия фактов и измерений. Факты — это числовые показатели бизнеса: суммы продаж, количество звонков, время обработки заказов и т. д. Измерения — это контекст, в котором происходят факты: товары, клиенты, время, география. Например, факт «продажа на 5000 рублей» анализируется по измерениям «товар — смартфон», «клиент — Иван Петров», «дата — 15 марта», «магазин — Москва, ТЦ Европейский».

Для организации фактов и измерений используют типовые схемы:

-

«звезда» — самая простая и популярная модель. В центре находится таблица фактов, от которой лучами расходятся таблицы измерений. Каждое измерение напрямую связано с фактами — это делает запросы быстрыми и понятными. Например, таблица фактов продаж связана с таблицами товаров, клиентов, времени и магазинов.

-

«снежинка» развивает идею звезды, добавляя нормализацию измерений. Таблица товаров может быть разделена на собственно товары, их категории и производителей. Это экономит место и поддерживает целостность данных, но усложняет запросы — нужно соединять больше таблиц.

-

«галактика», или созвездие фактов, объединяет несколько звёзд с общими измерениями. В хранилище может быть таблица фактов продаж и таблица фактов возвратов, которые используют одни и те же измерения товаров и клиентов.

Важный аспект моделирования — работа с изменяющимися данными. Технология SCD, Slowly Changing Dimensions, позволяет отслеживать историю изменений в справочниках. Например, если клиент переехал, система может сохранить как старый, так и новый адрес, чтобы правильно анализировать исторические данные.

После выбора архитектурного подхода и схемы данных начинается практическая работа по созданию хранилища.

Этапы проектирования DWH

Создание корпоративного хранилища данных — комплексный проект, который проходит через несколько последовательных этапов.

Этапы проектирования

|

Сбор требований |

Фундамент будущего хранилища. Аналитики встречаются с представителями бизнеса и выясняют, какие отчёты им нужны, какие показатели важны для принятия решений, с какой периодичностью требуется обновлять данные. Параллельно исследуются доступные источники: какие системы содержат нужную информацию, в каком она формате, насколько качественные данные. Результат этапа — чёткое понимание целей проекта и состава будущего хранилища. |

|

Проектирование концепции и модели данных |

Превращает бизнес‑требования в техническую архитектуру. Создаётся концептуальная модель — высокоуровневое описание основных сущностей и их взаимосвязей. Затем разрабатывают логическую модель с детальным описанием таблиц, полей, ключей и связей. На этом этапе выбирают методологию — Кимбалл или Инмон, определяют тип схемы данных, составляют план поэтапной реализации. |

|

Выбор платформы и архитектуры |

Определяет технологический стек проекта. Нужно решить, какую СУБД использовать для хранения — классическую реляционную, MPP‑систему или облачное решение. Выбирают инструменты для ETL‑процессов, средства мониторинга, BI‑платформу. Учитывают требования по объёмам данных, скорости обработки, бюджету и безопасности. Продумывают инфраструктуру: мощность серверов, объёмы хранилищ, схемы резервирования. |

|

Реализация и загрузка данных |

Самый трудоёмкий этап. Создают базы данных, таблицы, индексы согласно спроектированной модели. Разрабатывают ETL‑процессы: подключения к источникам, скрипты извлечения и преобразования данных, расписания загрузок. Особое внимание уделяют качеству данных — настраивают проверки на полноту, корректность, непротиворечивость. После отладки на тестовых данных выполняют историческую загрузку — в хранилище переносят данные за прошлые периоды. |

|

Тестирование и валидация |

Проверяет готовность системы к промышленной эксплуатации. Тестируют производительность — сможет ли хранилище обрабатывать запросы за приемлемое время при полной загрузке. Проверяют корректность расчётов — совпадают ли цифры в новых отчётах с проверенными источниками. Бизнес‑пользователи участвуют в приёмочном тестировании, оценивая удобство и полноту отчётов. |

|

Внедрение и запуск эксплуатации |

Переводит хранилище в рабочий режим. Настраивают регулярное обновление данных, пользователи получают доступ к витринам и отчётам, обучают работе с новыми инструментами. Первое время проектная команда работает вместе с пользователями, оперативно исправляя замечания и оптимизируя производительность. После запуска начинается не менее важная фаза — операционное управление хранилищем. |

После запуска начинается не менее важная фаза — операционное управление хранилищем.

Операционное управление DWH

Запущенное хранилище требует постоянного внимания и поддержки. От качества эксплуатации зависит, будет ли DWH приносить пользу бизнесу или превратится в дорогую игрушку:

-

Мониторинг и поддержка — основа стабильной работы. Системы мониторинга отслеживают десятки параметров: успешность ETL‑процессов, время выполнения запросов, объём свободного места, загрузку процессоров. Настроенные алерты мгновенно сообщают о проблемах — сбое загрузки данных, превышении времени обработки, подозрительной активности пользователей.

-

Версионирование изменений вводит порядок в развитие хранилища. Все изменения — новые таблицы, модификации ETL‑скриптов, обновления отчётов — проходят через систему контроля версий. Код хранится в Git‑репозиториях — это позволяет отследить, кто и когда внёс изменения, и при необходимости откатиться к предыдущей версии. Крупные изменения сначала тестируются в отдельной среде и только после проверки попадают в продакшн.

-

Управление метаданными помогает не потеряться в море данных. Современное хранилище содержит тысячи таблиц и полей — без документации разобраться в них невозможно. Системы управления метаданными хранят описания всех объектов: что означает каждое поле, откуда приходят данные, как часто обновляются, кто отвечает за качество.

-

Безопасность и управление доступом защищают конфиденциальную информацию. Реализуется ролевая модель: каждому пользователю назначаются права только на те данные, которые нужны для его работы. Все действия пользователей логируются — можно узнать, кто и когда запрашивал конкретные данные. Критичная информация шифруется как при хранении, так и при передаче.

Но даже при отличном операционном управлении проекты DWH сталкиваются с типовыми проблемами.

Проблемы при внедрении DWH

Создание корпоративного хранилища редко проходит гладко. Рассмотрим основные сложности и проверенные способы их преодоления.

Миграция из легаси‑систем часто становится головной болью проекта. В крупных компаниях данные десятилетиями накапливались в устаревших системах с экзотическими форматами и недокументированной логикой. Прямой перенос невозможен — нужно разбираться в структурах, искать зависимости, писать сложные конвертеры.

Решение — поэтапная миграция через промежуточное хранилище. Сначала данные выгружаются из старых систем «как есть», затем постепенно преобразуются и очищаются. Критически важные системы могут работать параллельно со старыми до полной проверки корректности.

Несогласованность метрик и данных проявляется, когда разные подразделения по‑своему считают одни и те же показатели. Например, маркетинг определяет активного клиента как сделавшего покупку за последний месяц, а финансисты — за последний квартал. В итоге в отчётах появляются разные цифры по одному показателю, и это подрывает доверие к хранилищу.

Решение — внедрение Data Governance, корпоративного управления данными. До начала проекта все заинтересованные стороны договариваются о единых определениях и правилах расчёта. Создаётся бизнес‑глоссарий с эталонными формулировками.

Высокая стоимость владения отпугивает многие компании от внедрения DWH. Лицензии на промышленные СУБД стоят десятки тысяч долларов

Решение — облачные хранилища данных. Вместо покупки железа арендуются вычислительные мощности, которые можно гибко масштабировать. Начать можно с пилотного проекта на минимальных ресурсах, постепенно расширяя систему по мере роста потребностей.

Низкое качество исходных данных — самая распространённая проблема. В операционных системах накапливаются ошибки: дубликаты клиентов, пропущенные поля, противоречивая информация. Если загрузить такие данные в хранилище, аналитические отчёты будут врать.

Решение — встраивание процессов контроля качества в ETL. На этапе загрузки данные проверяются десятками правил: суммы продаж не могут быть отрицательными, дата рождения клиента должна быть в разумных пределах, сумма частей должна равняться целому и т. д. Подозрительные записи проверяются вручную. Внедряется система метрик качества, которая показывает процент корректных данных по каждому источнику.

Несмотря на сложности, правильно спроектированное и внедрённое хранилище становится незаменимым инструментом для бизнеса. Но DWH — не единственный способ хранения больших данных.

Решения для хранения данных, отличные от DWH

Data Warehouse подходит для структурированной бизнес‑аналитики, но это не универсальное решение для всех задач с данными. Рассмотрим альтернативные подходы:

-

Data Lake — озеро данных — хранит информацию в сыром, необработанном виде. Если DWH — это аккуратно расставленные по полкам товары, то Data Lake — это склад, куда сваливается всё подряд: логи серверов, записи с видеокамер, посты из соцсетей, документы. Обработка происходит позже, когда появляется конкретная аналитическая задача. Такой подход дешевле в хранении и позволяет не терять потенциально ценную информацию. Data Lake незаменим для работы с Big Data, машинного обучения, анализа неструктурированных данных.

-

Data Mart — витрина данных — представляет собой специализированное хранилище для конкретного подразделения или бизнес‑процесса. В классической DWH‑архитектуре витрины строятся на основе централизованного хранилища с детальными интегрированными данными. Существует и альтернативный подход — построение независимых Data Mart напрямую из staging‑области, минуя централизованное DWH. Такие автономные витрины содержат только данные, необходимые конкретному подразделению — например, отделу маркетинга или финансовому департаменту. Они быстрее внедряются, проще в управлении и требуют меньше ресурсов. Компании часто начинают с создания отдельных витрин, а затем при необходимости объединяют их в полноценное хранилище.

На нашей платформе витрины данных удобно создавать на базе Yandex Managed Service for ClickHouse® — колоночной СУБД, оптимизированной для аналитических запросов. Сервис автоматически масштабируется, обеспечивает высокую скорость обработки и не требует глубоких знаний для начала работы.

ClickHouse®: рассказываем о колоночной СУБД для аналитики больших данных

Современные компании часто используют гибридные архитектуры: Data Lake для сбора сырых данных, DWH для структурированной аналитики, специализированные витрины для оперативных задач. Такой подход позволяет получить преимущества каждого решения.

Корпоративные хранилища данных в экосистеме Yandex Cloud

Создание DWH в облаке кардинально упрощает запуск проекта. Вместо закупки серверов и найма администраторов компания получает готовую инфраструктуру, которая масштабируется по требованию. Рассмотрим два основных подхода к построению аналитической платформы на нашей инфраструктуре.

Классический DWH на базе Greenplum®

Ядром традиционной архитектуры часто выбирают Yandex Managed Service for Greenplum® — управляемую MPP‑систему для обработки больших данных. Greenplum распределяет данные и вычисления между множеством узлов, обеспечивая линейный рост производительности при добавлении ресурсов. Сервис автоматически выполняет резервное копирование, мониторинг, обновление версий — всё, на что в традиционной инфраструктуре уходят месяцы работы.

Витрины данных строятся на Yandex Managed Service for ClickHouse® — быстрой колоночной СУБД. ClickHouse® обрабатывает миллиарды строк за секунды, что делает его подходящим для интерактивной аналитики.

Для потоковой обработки данных, выполнения сложных преобразований и построения моделей машинного обучения используется Yandex Managed Service for Apache Spark™. Это управляемый сервис для кластерных вычислений, который позволяет обрабатывать большие объёмы информации в реальном времени. Мы берём на себя большую часть работ по развёртыванию, настройке и обслуживанию кластера, а интеллектуальное масштабирование автоматически управляет ресурсами в зависимости от нагрузки.

Для задач, требующих более глубокого контроля или использования всей экосистемы Apache Hadoop®, предназначен сервис Yandex Data Processing. Он позволяет разворачивать кластеры с такими компонентами, как HDFS, YARN и HBase, и предоставляет полный root‑доступ к виртуальным машинам. Это даёт возможность гибко настраивать окружение и устанавливать собственные приложения на работающие кластеры без их перезагрузки.

Lakehouse — единая архитектура данных

Lakehouse объединяет архитектурные преимущества Data Lake и аналитическую мощь классического хранилища данных. Databricks впервые представил эту концепцию

В основе Lakehouse лежит единое хранилище с двумя режимами доступа. Сырые данные загружаются в объектное хранилище как в Data Lake: логи, JSON‑документы, видеопотоки, метрики IoT‑устройств. Но в отличие от классического озера, где данные лежат мёртвым грузом до момента обработки, Lakehouse предоставляет SQL‑движок для прямых запросов к этим файлам. Технологии табличных форматов — Apache Iceberg®, Delta Lake или Apache Hudi — создают поверх файлов транзакционный слой с ACID‑гарантиями, версионированием и оптимизацией запросов.

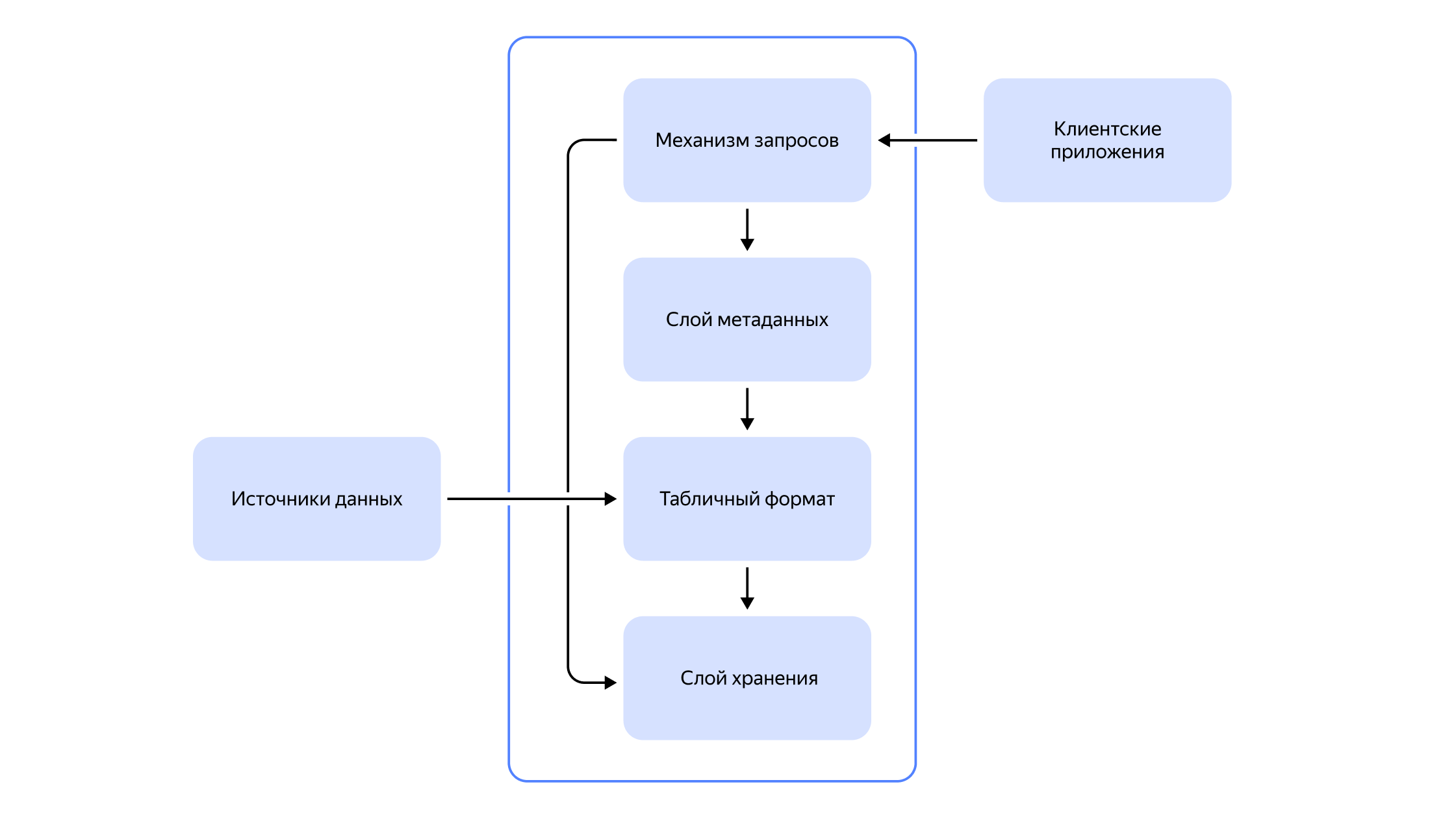

Модульная архитектура Lakehouse включает шесть компонентов:

-

Lake Storage — объектное хранилище для файлов любых типов с практически неограниченной масштабируемостью;

-

File Format — открытые колоночные форматы Apache Parquet или ORC для эффективного хранения и чтения данных;

-

Table Format — метаданные поверх файлов (Iceberg®, Delta Lake, Hudi), обеспечивающие ACID‑транзакции, схему эволюции и time travel;

-

Storage Engine — оркестрация задач кластеризации, компактификации и индексирования для оптимизации производительности;

-

Catalog — метастор для отслеживания всех таблиц и их метаданных;

-

Compute Engine — движки обработки (Spark™, Presto, Trino) для SQL‑запросов и ETL‑процессов.

Компоненты Lakehouse‑архитектуры и их взаимосвязи. Фундамент — слой хранения (storage layer), где масштабируемо, надёжно и экономично хранятся файлы данных и метаданные в открытом формате. Следующий компонент — уровень табличного формата (table format), например Iceberg®, Delta Lake или Apache Hudi, который управляет логической организацией данных в таблицы с поддержкой транзакций и версионности. Каталог метаданных (metadata layer) хранит схемы и правила, включает индексы и статистику. На верхнем уровне — движок запросов и управление Lakehouse для анализа и визуализации данных. Справа — клиентские приложения: инструменты BI и системы ETL/ELT, которые подключаются к Lakehouse для анализа и визуализации данных.

Реализация Lakehouse в Yandex Cloud

На нашей платформе архитектура Lakehouse строится на управляемых сервисах, которые объединяют гибкость озёр данных и производительность классических хранилищ.

Гибридная архитектура с управляемыми сервисами:

-

Yandex Managed Service for Apache Spark™ — для распределённой обработки.

-

Yandex Data Processing — для развёртывания и управления кластерами Apache Hadoop® и сервисами его экосистемы (такими как HDFS, YARN и HBase).

-

Yandex Object Storage как единое озеро данных для хранения в открытых форматах.

-

Yandex Managed Service for ClickHouse® — для быстрой аналитики и витрин данных.

-

Yandex Managed Service for Trino — для SQL‑запросов к данным в объектном хранилище.

-

Yandex Data Transfer — для репликации между системами без написания ETL‑кода.

YTsaurus (подробнее о нём расскажем дальше) как универсальная платформа данных:

- YTsaurus предоставляет полноценную Lakehouse‑функциональность с распределённой файловой системой, поддержкой ACID‑транзакций, SQL‑движком и интеграциями с популярными фреймворками обработки данных.

Lakehouse против классического DWH: критерии выбора

|

Критерий |

Классический DWH |

Lakehouse |

|

Стоимость хранения |

Высокая (блочное хранилище) |

На порядок ниже благодаря объектному хранилищу |

|

Типы данных |

Только структурированные |

Любые: структурированные, полуструктурированные, неструктурированные |

|

Доступ для ML |

Через ODBC/JDBC |

Прямой доступ к Parquet/ORC файлам через pandas, TensorFlow, PyTorch® |

|

Актуальность данных |

ETL с задержками в дни |

Обработка почти в реальном времени, устранение промежуточного ETL |

|

Привязка к поставщику |

Проприетарные форматы |

Открытые форматы Parquet, ORC, Avro |

|

Масштабируемость |

Вертикальная |

Горизонтальная через разделение Compute и Storage |

Экосистема интегрированных сервисов

Оба подхода поддерживаются интегрированными сервисами:

-

Yandex Object Storage — для хранения сырых данных и бэкапов,

-

Yandex Data Transfer — для репликации данных между системами,

-

Yandex Identity and Access Management — для управления доступом,

-

Yandex Monitoring — для отслеживания состояния всех компонентов,

-

Yandex Audit Trails — для соответствия требованиям безопасности.

Главное преимущество облачного подхода — скорость запуска. Развернуть пилотное хранилище можно за несколько часов. Платить нужно только за реально используемые ресурсы — если в выходные нагрузка падает, счета автоматически уменьшаются. При пиковых нагрузках система автоматически добавляет мощности.

Более 80% используемых сервисов основаны на опенсорс‑решениях. Это снимает вендорлок — при необходимости можно перенести данные и процессы в другую инфраструктуру. Команды со своей экспертизой могут тонко настраивать системы под свои задачи.

Разверните DWH — мы поможем

Эксперты подберут архитектуру для проекта, рассчитают стоимость реализации и подскажут, как внедрить решения. Развернуть корпоративное хранилище в облаке можно с помощью гранта.

Построенное хранилище нужно ещё и эффективно использовать — для этого требуются правильные инструменты анализа.

Multi‑Version Concurrency Control — механизм управления параллельным доступом к данным.

Access Control List — список контроля доступа.

Инструменты для анализа данных

Собрать данные в хранилище — только половина дела. Чтобы информация приносила пользу бизнесу, нужны инструменты для её анализа и визуализации.

Платформа данных YTsaurus

В Яндексе мы с 2010‑го развиваем собственную платформу анализа данных — YTsaurus

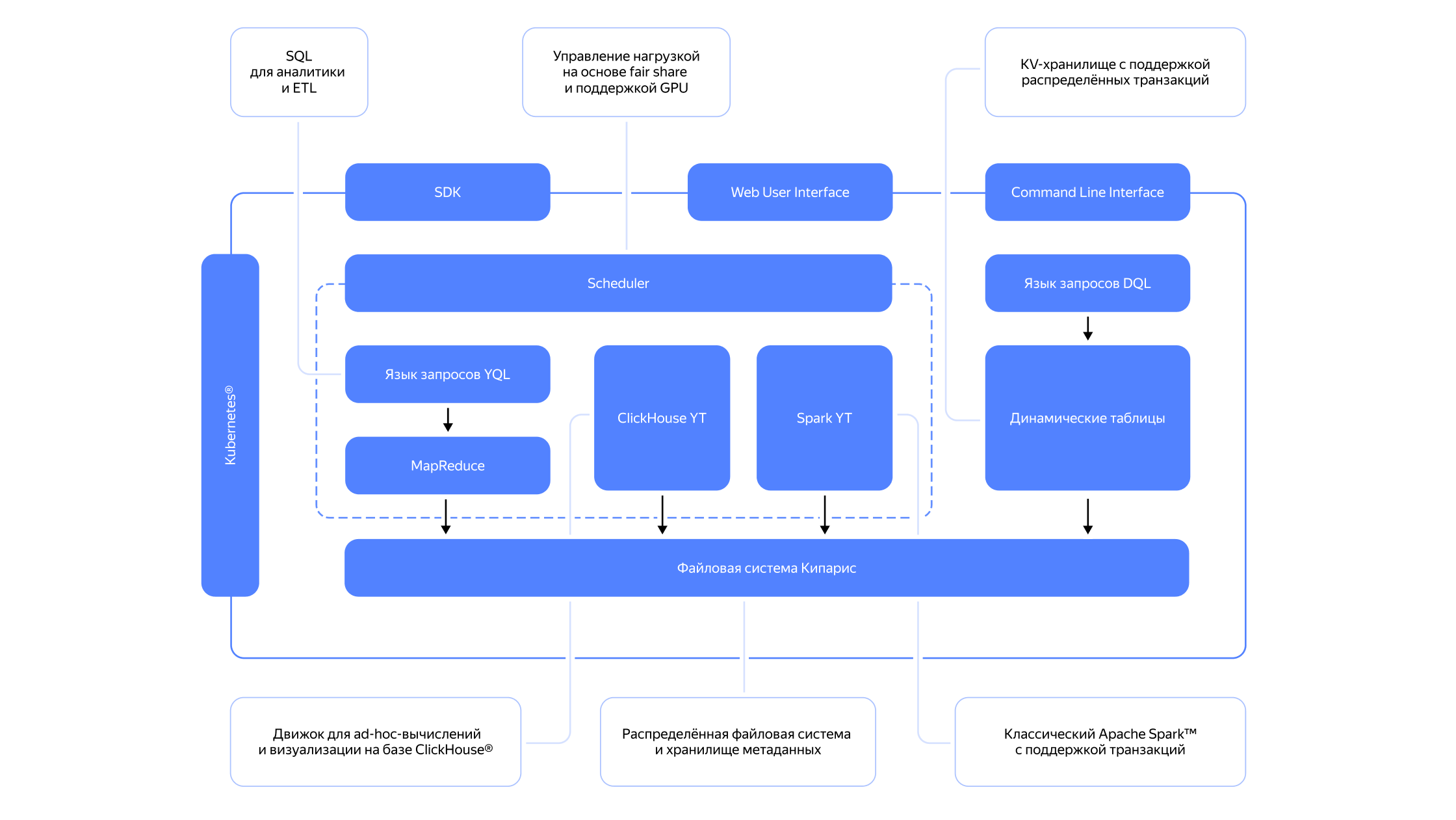

В отличие от СУБД в классическом понимании, YTsaurus представляет собой платформу данных с несколькими инструментами обработки на базе распределённой файловой системы. Технические пределы масштабируемости платформы обычно ограничены только ёмкостью ЦОД. Архитектура поддерживает как пакетные, так и близкие к реальному времени нагрузки, при этом кластер можно расширять серверами различных типов — для хранения данных, CPU или GPU‑ресурсов. Развёртывание происходит через Kubernetes®‑оператор — это позволяет работать как в ЦОД клиента, так и в облачной инфраструктуре.

YTsaurus включает в себя:

-

MapReduce‑реализацию языка YQL для пакетной обработки запросов;

-

ClickHouse over YT для создания интерактивных дашбордов;

-

Spark over YT для обработки данных с использованием среды на основе последних версий Apache Spark;

-

Key‑value‑обработку запросов для работы с очередями и задачами, близкими к реальному времени;

-

распределённую файловую систему Кипарис с поддержкой распределённых транзакций MVCC и контролем прав доступа на основе ACL.

Архитектура платформы YTsaurus построена на модульном принципе с несколькими уровнями обработки данных. В основе лежит распределённая файловая система Кипарис, которая обеспечивает хранение данных и метаданных с поддержкой распределённых транзакций. Над файловой системой работают различные движки обработки: MapReduce для пакетной обработки с языком запросов YQL, ClickHouse YT для интерактивной аналитики и ad‑hoc‑вычислений, Spark YT для классических Spark‑задач с поддержкой транзакций. Отдельно выделены динамические таблицы, которые работают как KV‑хранилище с поддержкой распределённых транзакций. Планировщик (Scheduler) координирует выполнение задач, управляя нагрузкой на основе механизма fair share и поддерживая GPU‑вычисления. Для взаимодействия с платформой предусмотрены SDK для SQL‑запросов и ETL‑процессов, веб‑интерфейс и интерфейс командной строки. Вся система работает под управлением Kubernetes® — это обеспечивает оркестрацию контейнеров и масштабирование компонентов платформы.

Платформа не навязывает конкретную аналитическую архитектуру. YTsaurus одинаково хорошо подходит для построения классических хранилищ данных по методологиям Иммона или Кимбала. При этом платформа работает с современными архитектурами — Lakehouse и Data Lake.

Сервис бизнес‑аналитики Yandex DataLens

Yandex DataLens — сервис бизнес‑аналитики, созданный специально для работы с большими данными. Подключается к любым источникам: от Excel‑файлов до промышленных СУБД. Можно одновременно анализировать данные из разных систем, объединяя их в одном дашборде.

Создание визуализаций не требует программирования. Пользователь перетаскивает нужные поля на график, выбирает тип визуализации, настраивает фильтры — и получает интерактивный отчёт. Десятки типов графиков покрывают любые потребности: от простых столбчатых диаграмм до сложных географических карт и воронок конверсии.

Диаграммы и графики: как выбрать правильную визуализацию данных

Дашборды обновляются автоматически при изменении данных в источниках. Можно настроить алерты — система сама сообщит, если ключевые показатели выйдут за установленные границы. Отчёты легко публикуются для коллег с разграничением прав доступа.

DataLens интегрирован с облачными сервисами, но работает и с внешними источниками. Это позволяет начать аналитику ещё до полного переезда в облако — можно подключиться к существующим базам и постепенно мигрировать данные.

Для переноса данных между системами мы создали Yandex Data Transfer — сервис, который автоматизирует репликацию. Вместо написания сложных скриптов достаточно указать источник и приёмник — сервис сам определит схему данных, настроит потоки, обеспечит целостность при передаче. Поддерживаются десятки типов источников: от PostgreSQL до Apache Kafka®.

Комплексный подход к хранению и анализу данных даёт компаниям конкурентное преимущество. Решения принимаются на основе фактов, а не интуиции. Скрытые закономерности становятся очевидными. Прогнозы строятся на исторических данных, а не на догадках.

Корпоративное хранилище данных — это инвестиция в будущее компании. Да, проект требует усилий и ресурсов. Но результат — единый источник правды о бизнесе, мгновенные ответы на сложные вопросы, обоснованные стратегические решения — окупает все затраты.

Если нужна помощь в проектировании архитектуры или возникли вопросы по внедрению — обращайтесь к нашим экспертам. Партнёры Yandex Cloud помогут спроектировать оптимальное решение под задачи вашего бизнеса и возьмут на себя техническую поддержку.

В этой статье:

- Сценарии использования DWH

- Отличия DWH от транзакционной базы данных

- Архитектура DWH

- Моделирование данных в DWH

- Этапы проектирования DWH

- Операционное управление DWH

- Проблемы при внедрении DWH

- Решения для хранения данных, отличные от DWH

- Корпоративные хранилища данных в экосистеме Yandex Cloud

- Инструменты для анализа данных