Такая технология подходит компаниям, где необходимы узкоспециализированные знания, например, о внутренних процессах или актуальном ассортименте интернет‑магазина. Эти данные нельзя заранее включить в общий датасет, поскольку они уникальны и постоянно меняются.

RAG: учим искусственный интеллект работать с новыми данными

Современные модели вроде GPT‑4 и YandexGPT не умеют сами узнавать новое. RAG учит их быстро находить и использовать свежую информацию — без переобучения и галлюцинаций.

- RAG (Retrieval Augmented Generation) — это технология, которая соединяет языковую модель с внешней базой знаний, что позволяет AI-помощнику находить релевантные документы и генерировать ответы на основе актуальных данных.

- В системах RAG используются три основных понятия: чанкование (нарезка), чанк и пайплайн, которые помогают обрабатывать большие тексты и создавать ответы.

- Токенизация — это процесс разделения текста на минимальные смысловые или технические единицы (токены), который является первым шагом в обработке текста для RAG-систем.

- Чанкование — это процесс формирования блоков текста (чанков) из токенов, который позволяет эффективно работать с текстом в RAG-системах.

- Пайплайн — это последовательность этапов обработки текста, включая индексацию, поиск, подготовку задания, генерацию и проверку ответа.

- RAG-система состоит из двух главных частей: поисковика и языковой модели, которые работают последовательно для поиска релевантных данных и генерации ответа.

- RAG позволяет получать точные ответы на основе актуальных данных в контексте конкретной задачи, что делает его полезным для различных бизнес-приложений.

- Примеры задач для RAG включают внутренние справочники для сотрудников, отчёты с проверкой фактов, консультантов интернет-магазинов и подсказки для операторов техподдержки.

- RAG решает проблемы стандартных языковых моделей: устаревшие знания и склонность выдумывать несуществующие факты, благодаря использованию внешних источников данных.

- При внедрении RAG необходимо учитывать проблемы с базой знаний, неточности при поиске информации, выдуманные факты, увеличение времени ответа и безопасность информации.

- Будущее RAG связано с развитием умных агентов, которые смогут самостоятельно решать, какие инструменты использовать для поиска информации и как лучше ответить на вопрос.

Современные языковые модели вроде YandexGPT 5 Pro

Из‑за этого модели не всегда могут ответить на специфичные бизнес‑вопросы — например, о текущем ассортименте товаров или деталях внутренних процессов компании.

В статье расскажем, как технология RAG помогает языковым моделям быстро находить и использовать свежие данные, для каких задач подходит лучше всего, чем отличается от других подходов и как запустить такое решение с помощью сервисов Yandex Cloud.

Что такое RAG

RAG (Retrieval Augmented Generation — генерация с дополненной выборкой) соединяет языковую модель с внешней базой знаний. AI‑помощник на базе RAG сначала находит релевантные документы во внешних источниках с помощью, например, векторного поиска, ранжирует найденную информацию, а затем генерирует ответ на запрос пользователя на основе этих данных.

Этот подход существенно снижает вероятность устаревания данных и возникновения галлюцинаций, типичных для обычных языковых моделей. Например, чат‑бот клиентской поддержки, AI‑консультант на сайте или HR‑помощник должны отвечать не на основе всего интернета, а опираясь на конкретную базу знаний компании. RAG упрощает это: разработчик готовит базу знаний из конкретных файлов, текстов или документов, а модель автоматически ищет информацию именно в ней. При этом не нужно переучивать модель — достаточно обновлять внешние источники данных.

Сейчас уже существуют сервисы, использующие подходы, схожие с RAG, для проверки фактов в интернете. Например, Perplexity

Например, корпоративный помощник с RAG легко отвечает на вопросы о новых продуктах. Он просто находит актуальные материалы во внутренних документах и использует их для формирования ответа. Так компания получает виртуального консультанта, который всегда владеет свежей информацией и прекрасно разбирается в продуктах компании.

Базовые понятия RAG: просто о сложном

В системах RAG важны три главных понятия: чанкование (нарезка), чанк и пайплайн. Эти элементы помогают превратить большие тексты в удобные части для поиска и создания ответов.

Токенизация и чанкование: что это и в чём разница

Обработка длинных текстов всегда начинается с токенизации. Токенизация — это процесс разделения исходного текста на токены: минимальные смысловые или технические единицы. Для разных языков и задач токен может быть словом, частью слова, символом или даже байтом.

На слишком больших вводных данных модели работают менее эффективно.

Компонент, который ищет и извлекает релевантные фрагменты текста (чанки) из базы знаний для дальнейшей работы модели.

Языки с богатой морфологией, сложными правилами словообразования и большим количеством грамматических форм. Например, к таким относят русский, финский и венгерский.

Пример токенизации (английский):

Текст: «Machine learning is powerful.»

Токены: [«Machine», «learning», «is», «powerful», «.»]

Пример токенизации (русский):

Текст: «Машинное обучение — это интересно.»

Токены: [«Машинное», «обучение», «—», «это», «интересно», «.»]

Чтобы языковая модель могла эффективно работать с текстом, токены объединяют в более крупные блоки — чанки — фрагменты текста, которые используют как единицы поиска и обработки информации.

Обычно чанк совпадает с абзацем, предложением или представляет собой фрагмент фиксированной длины — на практике от ≈ 128 до ≈ 1 000 токенов, в зависимости от используемой модели и специфики задачи: чем больше модель допускает контекст, тем крупнее может быть чанк. Процесс формирования таких блоков называют чанкованием: текст разбивают на чанки либо по смысловым границам, либо по заданному числу токенов, чтобы сохранить связность информации и обеспечить эффективную работу retrieval‑системы и генеративной модели.

Способы токенизации и чанкования

Существует несколько подходов к токенизации:

- По пробелам (whitespace tokenization): простейший способ, применяется для языков с чёткой границей между словами.

- Byte Pair Encoding, WordPiece, Unigram: используются в современных моделях — разбивают слова на подслова или даже отдельные символы для повышения гибкости.

- Морфологическая токенизация: для сложных языков — с учётом грамматики.

Для чанкования:

- Применяют фиксированный размер чанка: каждая часть содержит одинаковое число токенов.

- Делят по смысловым границам: деление по абзацам, предложениям, заголовкам.

- Применяют метод с перекрытием (overlap): части текста пересекаются, чтобы не терять смысл на стыках.

Лучше всего разрезать текст по смысловым границам — так модель не потеряет важные факты и корректно поймёт контекст.

По пробелам — токенизация, при которой текст делится на слова и знаки препинания по пробелам.

BPE (Byte Pair Encoding) — алгоритм, разбивающий текст на часто встречающиеся сочетания символов или частей слов.

WordPiece — метод, который делит слова на наиболее информативные подслова для лучшего охвата словаря.

BERT использует токенизацию WordPiece, при которой слова разбиваются на информативные подслова. Это помогает эффективно работать с редкими и новыми словами.

GPT применяет byte‑level BPE — токенизацию на уровне байтовых пар, что позволяет обрабатывать любые символы, включая редкие и нестандартные.

Фреймворки и настройка токенизации

Для токенизации и чанкования существуют разные фреймворки — Hugging Face Tokenizers, SentencePiece, spaCy, NLTK и другие. Каждый из них предоставляет гибкие настройки:

- Можно выбрать тип токенизации: например, whitespace, BPE (обычно для GPT), WordPiece (обычно для BERT), Unigram или морфологический подход. Некоторые фреймворки, такие как SentencePiece, объединяют несколько подходов.

- Есть возможность настраивать размер чанков, перекрытия и стратегию разбиения — по токенам, предложениям, абзацам.

- Поддерживается адаптация под конкретные языки, домены и даже отдельные архитектуры моделей: например, для BERT — WordPiece, для GPT — byte‑level BPE.

Это позволяет оптимально подготовить текст для разных задач: от поиска до генерации.

Пайплайн: как всё работает вместе

Пайплайн — это последовательность этапов обработки текста, где каждый этап чётко выполняет свою функцию. Все этапы интегрируются в единую цепочку для эффективной работы RAG‑системы.

Обычный пайплайн включает пять шагов:

- Индексация — разрезание документов на чанки, преобразование их в векторное представление (эмбеддинги) и сохранение в базе для быстрого поиска.

- Поиск — определение нужных чанков по запросу пользователя.

- Подготовка задания — формирование промта, соединяя запрос пользователя с найденными чанками, чтобы языковая модель получила контекст для генерации ответа.

- Генерация — создание ответ с помощью языковой модели.

- Проверка — контроль качества ответа, проверка его точности и отсутствия галлюцинаций. По необходимости можно добавить ссылки на источники данных.

Специальные библиотеки по типу LangChain, LlamaIndex и Langflow позволяют собрать такой пайплайн из готовых компонентов. Можно выбрать разные модели для векторизации и генерации текста, но общая структура процесса остаётся одинаковой.

Такие решения обычно требуют понимания основных концепций и предварительного знакомства с технологиями, что может занимать время. Проще и быстрее собрать пайплайн с помощью AI Assistant API в Yandex AI Studio — платформа предлагает готовые компоненты и упрощённый интерфейс, снижая порог входа для новичков в AI‑инструментах.

Из чего состоит RAG‑система

RAG работает благодаря двум главным частям: поисковому индексу и языковой модели. Эти две части работают последовательно: поисковик находит релевантные данные, затем языковая модель использует их для генерации ответа.

Поисковик

Поисковик преобразует запрос и чанки в числовое представление (эмбеддинги) и ищет похожие по смыслу фрагменты. Для эффективного хранения и поиска эмбеддингов используются специальные векторные базы данных и индексы.

В Yandex Cloud для реализации семантического поиска и построения RAG‑систем можно использовать сервис Search Index. Он позволяет создавать и управлять как классическими индексами (на основе алгоритма BM25), так и векторными индексами (с использованием нейронных эмбеддингов). Это особенно полезно для задач, где важно учитывать смысловую близость текста, а не только совпадение ключевых слов.

Search Index поддерживает два основных подхода к поиску:

- BM25 — классический алгоритм поиска по ключевым словам, основанный на частоте их встречаемости в документах.

- Нейронные эмбеддинги — метод, при котором тексты преобразуются в числовые векторы, отражающие их смысловое содержание. Это позволяет находить фрагменты, близкие по смыслу, даже если в них используются разные формулировки.

Языковая модель

Она формирует ответ на основе запроса и найденных фрагментов. Для RAG‑сценариев важна не столько мощность модели, сколько её способность точно и надёжно использовать предоставленный контекст. Разные модели могут демонстрировать различную эффективность в таких задачах.

По результатам внутренних тестов Яндекса, проведённых в различных RAG‑сценариях (ответы на вопросы с использованием базы знаний), YandexGPT 5 Pro показала

Это делает её эффективным выбором для бизнес‑приложений, где необходимо существенно снизить вероятность галлюцинаций и обеспечить достоверность ответов на основе актуальных данных.

Модель можно дополнительно дообучить на сценариях формата «вопрос плюс документы», чтобы повысить качество и точность ответов. Современные модели и без дообучения могут работать с этим форматом, однако при необходимости строго соблюдать определённый стиль, терминологию или структуру ответов дообучение становится обязательным этапом.

Но если модель должна отвечать в определённом формате или соблюдать специфический Tone of Voice компании, то дообучение становится необходимым этапом. Это позволяет добиться стабильности и предсказуемости ответов, которые будут точно соответствовать ожиданиям бизнеса.

Для каких задач используется RAG

RAG позволяет получать точные ответы на основе актуальных данных в контексте конкретной задачи. Технология особенно полезна там, где крайне важно минимизировать ошибки и своевременно обновлять информацию. Компании внедряют RAG, когда хотят соединить возможности искусственного интеллекта с проверенными фактами из собственных надёжных источников.

Примеры задач для RAG:

-

Внутренние справочники для сотрудников. Новым сотрудникам больше не нужно изучать десятки документов о правилах компании. Они задают вопрос в чате, а RAG‑система находит нужную информацию в корпоративных базах и даёт понятный ответ, при необходимости сопровождая его ссылками на первоисточники.

-

Отчёты с проверкой фактов. Юристы и аудиторы используют RAG для подготовки документов. Система может автоматически дополнять каждый факт и числовой показатель ссылкой на источник данных, что облегчает проверку и повышает доверие к информации.

-

Консультанты интернет‑магазинов. Пользователи задают вопросы о товарах, а модель, интегрированная с постоянно обновляемой товарной базой или CMS, оперативно отвечает о характеристиках, условиях возврата, гарантии и доставке. Такие помощники отвечают быстрее и круглосуточно, независимо от часов работы магазина, что повышает удовлетворённость клиентов.

-

Подсказки для операторов техподдержки и контакт‑центров. RAG‑модель использует информацию из истории обращений пользователя и данные о подключённых услугах, чтобы найти подходящее решение проблемы в базе знаний поддержки. Оператор получает подсказку с кратким описанием и готовым вариантом ответа, что позволяет быстро и качественно решать вопросы.

Чем RAG лучше обычных языковых моделей

RAG решает две главные проблемы стандартных языковых моделей — устаревшие знания и склонность выдумывать несуществующие факты.

Всегда свежие данные без лишних затрат

Благодаря тому, что RAG берёт информацию из внешних источников, не нужно полностью переобучать модель при каждом обновлении данных. Достаточно регулярно обновлять базу документов, с которой она работает. Это существенно снижает расходы и обеспечивает актуальность ответов.

Прозрачность и проверяемость

RAG позволяет легко проверить полученную информацию. Система способна не только выдавать ответ, но и показывать, откуда взяты факты. При соответствующей настройке к ответу могут прилагаться ссылки на документы, из которых взята информация. Это упрощает проверку — пользователь может увидеть оригинал текста, а юристы и специалисты по безопасности сразу видят источник каждого факта или цифры.

В Yandex Cloud AI Studio доступно готовое решение AI Assistant API, поддерживающее цитирование источников. Оно возвращает данные о конкретных фрагментах документов, использованных для формирования ответа, которые могут отображаться как активные ссылки на документы в Yandex Object Storage или корпоративной базе знаний.

Меньше выдуманных фактов

RAG значительно снижает вероятность галлюцинаций. Поскольку система опирается на конкретные источники, она намного реже придумывает информацию. Но полностью исключить возможность ошибок нельзя, поэтому критически важные данные всегда требуют дополнительной проверки.

RAG или другие методы: что выбрать

RAG — не единственный способ поддерживать актуальность ответов больших языковых моделей. Существуют и другие подходы, у каждого есть свои плюсы и минусы.

|

Подход |

Плюсы |

Минусы |

|

RAG |

|

|

|

Fine-tuning |

|

|

|

LLM с длинным контекстом |

|

|

|

Классический поиск |

|

|

Дообучение модели (Fine-tuning)

При дообучении модель настраивается на нужный формат, стиль и специфику ответов по примерам, а не получает новые факты о мире. Этот метод обеспечивает высокую точность в узких темах, но требует:

- мощных компьютеров для обработки данных

- регулярного повторения процесса при появлении новой информации

- значительных затрат на вычисления

Модели с длинным контекстом

Некоторые модели могут читать десятки тысяч слов за раз. Они анализируют все документы целиком без предварительного поиска нужных частей. Этот метод:

- даёт высокое качество ответов

- позволяет модели видеть всю картину

- сильно увеличивает стоимость работы

- чувствителен к лишней или «шумной» информации

Исследования

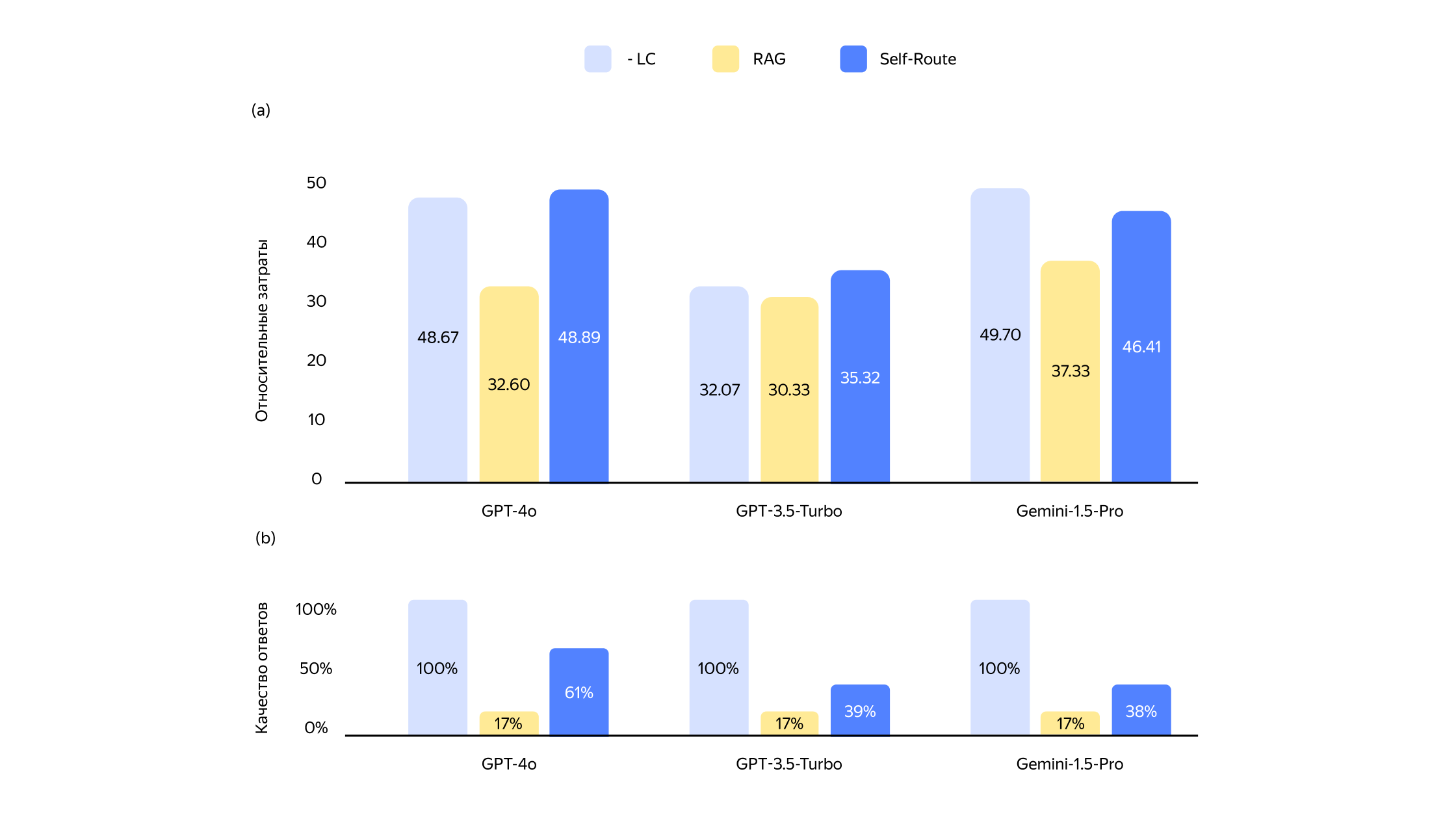

Иллюстрация результатов исследования Google DeepMind. На первом графике представлено качество ответов, а на втором — относительные затраты для трёх методов: модели с длинным контекстом, RAG и гибридного метода Self‑Route. LC‑модели, такие как GPT‑4o, показывают высокое качество ответов, но их использование требует значительных ресурсов. RAG уступает по качеству, но существенно выигрывает в стоимости. Гибридный подход Self‑Route автоматически выбирает наиболее подходящий метод для каждого запроса и обеспечивает качество, близкое к LC, при более низких затратах. Источник: Google DeepMind

Классический поиск

Классический поиск просто показывает список ссылок на релевантные веб‑страницы, статьи и документы без их автоматической обработки. Пользователю приходится самому читать материалы и делать выводы. Такой подход работает быстро и стоит недорого, но перекладывает всю работу на человека. Есть риск, что пользователь пропустит важные детали или неправильно поймёт информацию.

Когда RAG может не подойти

Несмотря на множество преимуществ, RAG — не всегда идеальное решение. Вот ситуации, когда стоит рассмотреть другие подходы.

Работа с очень большими и сложными данными

Когда требуется анализировать большие массивы информации со сложными взаимосвязями, модели с длинным контекстом могут показать лучший результат, поскольку видят полную картину. Но при слишком большом объёме данных точность может снижаться, и модели могут не справиться с детализацией и правильной интерпретацией всех взаимосвязей.

Нехватка качественных источников

RAG напрямую зависит от качества базы данных. Если по теме мало надёжных источников, RAG‑система не сможет давать точные ответы. В таких случаях стоит рассмотреть дообучение модели (Fine‑tuning) на имеющихся источниках — это позволит улучшить качество и точность ответов даже при ограниченной информации.

Задачи с высокими творческими требованиями

При создании оригинального творческого контента строгие рамки существующих источников, которые использует RAG, могут излишне ограничивать модель. Базовые генеративные модели, не привязанные к жёстким источникам, часто лучше справляются с задачами, где важна оригинальность и творческая свобода.

Очень динамичные данные в реальном времени

Если информация меняется каждую секунду (например, биржевые котировки), даже RAG не всегда успевает своевременно обновлять базу данных. В таких случаях обычно применяют специализированные потоковые системы или дополняют RAG полноценными AI‑агентами, способными автономно запрашивать текущие данные через внешние API с помощью функционала Function Calling.

В сложных проектах часто применяют комбинацию подходов, чтобы нивелировать недостатки отдельных методов и максимально использовать их преимущества. Например, RAG используется для большинства задач благодаря точности и актуальности, а модели с длинным контекстом подключаются для более глубокого анализа сложных вопросов.

Как запустить RAG в Yandex Cloud

Загрузка корпоративных документов

Для унификации и упрощения предварительной обработки текстовых данных часто используют формат Markdown, но модели также могут работать с другими распространёнными форматами — например, .txt, .docx и .xlsx.

Для преобразования документов в единый удобный формат можно использовать библиотеку Docling или аналогичные инструменты. После подготовки файлы загружаются в Yandex Cloud через Files API.

Общее ограничение — 10 000 файлов до 128 МБ каждый на один каталог (folder). Ассистент получает доступ к файлам не напрямую, а через созданный позже поисковый индекс.

При создании поискового индекса документ автоматически делится на фрагменты (чанки) примерно по 700 токенов — минимальных единиц текста, которые могут быть словами, частями слов или отдельными символами, с перекрытием примерно 300 токенов. Это оптимальные параметры для русского языка, но они требуют проверки на данных.

Создание поискового индекса

Поисковый индекс ускоряет поиск информации в загруженных документах. В Yandex Cloud доступны три типа индекса:

- текстовый — классический поиск по точным ключевым словам.

- векторный — поиск по смыслу с использованием нейросетевых моделей (эмбеддингов), которые находят документы по близким по значению запросам.

- гибридный — сочетание текстового и векторного поиска.

Для гибридного поиска нужно явно выбрать стратегию объединения результатов:

- Reciprocal Rank Fusion (RRF) — приоритет отдаётся наиболее релевантным фрагментам каждого типа поиска.

- Mean_combination — результаты усредняются (по умолчанию — среднее арифметическое).

Настройки разбиения на чанки должны совпадать у текстового и векторного индекса — это повысит качество поиска. Результаты поиска по умолчанию нормализуются с помощью метода MIN_MAX, приводя оценки релевантности к единой шкале. Но для стратегии RRF нормализация не оказывает значительного влияния.

Создание ассистента

С помощью AI Assistant API выбирается модель, например, YandexGPT Pro, задаётся системный промт — базовая инструкция, задающая поведение ассистента, — после чего подключается созданный поисковый индекс. Для работы нужны роли ai.assistants.editor и ai.languageModels.user.

Ассистент формирует каждый ответ, автоматически дополняя вопрос фрагментами из документов — это и есть механизм работы RAG.

Интеграция ассистента с приложением

Доступ к ассистенту организован через REST (результат возвращается целиком после завершения обработки запроса) и gRPC (поддерживает потоковую передачу данных — ответ формируется постепенно)Если ассистент использует данные из подключённого индекса, в результатах появляется раздел citations — ссылки на конкретные фрагменты использованных документов.

Если ассистент использует данные из подключённого индекса, в результатах появляется раздел citations — ссылки на конкретные фрагменты использованных документов. Если индекс не использовался, citations не отображается.

Управление процессом (оркестрация)

Ассистент сам формирует запросы, объединяя вопросы и релевантные фрагменты. Для дополнительной автоматизации и расширения возможностей можно использовать специальные инструменты (фреймворки) LangChain или LlamaIndex.

Срок хранения документов

Файлы и индексы автоматически удаляются после долгого периода неиспользования. Срок хранения можно индивидуально настроить с помощью параметра ExpirationConfig, регулируя жизненный цикл данных.

На что обратить внимание при внедрении RAG

RAG значительно улучшает работу языковых моделей, но не является идеальным решением. При внедрении могут возникнуть сложности, которые лучше предусмотреть заранее.

Проблемы с базой знаний

Качество ответов напрямую зависит от документов в базе. Если информация устарела или содержит дубликаты, модель выдаст неточный ответ. Для решения проблемы нужно:

- регулярно актуализировать документы в базе знаний и пересчитывать их векторные представления

- удалять ненужные файлы

- отслеживать версии документов

Неточности при поиске информации

Векторный поиск иногда может подбирать фрагменты, которые кажутся похожими по смыслу из‑за сходства эмбеддингов, но фактически содержат нерелевантную информацию. Это можно исправить комбинацией подходов:

- сочетать семантический поиск с классическим алгоритмом BM25

- использовать языковую модель для проверки найденных фрагментов

Выдуманные факты

Даже с правильным контекстом модель может добавить в ответ выдуманные детали. Чтобы этого избежать, нужно:

- всегда сопровождать ответы ссылками на источники, чтобы пользователи могли проверить факты

- чётко инструктировать модель отвечать строго на основе предоставленных текстов

Увеличение времени ответа

RAG работает дольше, чем языковая модель сама по себе, — нужно время на поиск и обработку информации. Для ускорения важно:

- оптимизировать поисковый индекс

- использовать асинхронный режим для сложных запросов

- создавать кеш ответов для наиболее частых и повторяющихся вопросов, чтобы снизить нагрузку и ускорить обработку

Безопасность информации

RAG‑система получает доступ к корпоративным данным, поэтому требует особой защиты:

- шифрования хранилища данных

- ограничения доступа к системе — например, с помощью Yandex Identity and Access Management

- записи истории запросов — например, в Yandex Cloud Logging, для мониторинга, безопасности и аудита

Удобство использования

Для повышения доверия пользователей к системе важно:

- показывать ответы в удобном интерфейсе: чате, веб‑виджете, голосовом помощнике

- добавлять ссылки на источники информации

- собирать оценки точности ответов для улучшения системы

Другие технические нюансы

Для стабильной работы RAG важно соблюдать несколько простых правил:

- тщательно очищать данные перед добавлением в систему

- хранить векторные представления в быстрой памяти

- не перегружать контекст и использовать только наиболее важные фрагменты, оптимизируя объём контекста (обычно около 1000–1500 токенов) для баланса между полнотой информации и скоростью работы модели

Такой подход делает обслуживание системы проще: можно обновлять базу знаний независимо от языковой модели и гибко распределять нагрузку между поиском и генерацией ответов.

Будущее RAG: что дальше

Сегодня большинство RAG‑систем работают по простой и распространённой схеме: поисковик находит информацию, а языковая модель создаёт ответ на её основе. При этом модель пассивно ждёт, когда ей предоставят нужные фрагменты текста. Следующий шаг развития — сделать искусственный интеллект более самостоятельным.

Умные агенты вместо пассивных помощников

Новое поколение RAG‑систем сможет само решать, какие инструменты использовать для поиска информации и как лучше ответить на вопрос. Вот главные направления развития:

- Agent‑RAG — агентный RAG. Модель получает доступ к набору инструментов: разным видам поиска, внутренним базам данных, генераторам изображений и другим сервисам. Агент не просто выбирает последовательность действий, но и способен адаптивно корректировать её, проверять промежуточные результаты и уточнять запросы при необходимости.

- Self‑Route — самостоятельная маршрутизация. Умная система самостоятельно оценивает сложность вопроса и выбирает наиболее подходящую модель или комбинацию моделей — от простого RAG‑подхода до моделей с длинным контекстом. Это позволяет оптимизировать затраты и производительность без потери качества.

- Мультимодальный RAG. Будущие мультимодальные системы смогут полноценно работать не только с текстом, но и с изображениями, аудио, видео и структурированными данными, такими как таблицы. Они будут не просто искать информацию в разных форматах, но и анализировать, интерпретировать и интегрировать её в едином ответе. Такой подход особенно полезен для технической поддержки, медицины и интернет‑магазинов, где важно работать с разными форматами данных.

RAG уже стал стандартом для корпоративных решений с искусственным интеллектом. Следующий этап развития — появление умных агентов, обладающих автономностью и адаптивностью. Они смогут самостоятельно комбинировать поиск, создание контента и использовать различные инструменты, что позволит им эффективно и гибко решать гораздо более сложные и разнообразные задачи.

В этой статье: