Архитектура системы, разработанная для обеспечения непрерывной работы и минимизации времени простоя, как правило, за счёт резервирования.

Главный узел в распределённой системе, который обрабатывает операции записи и/или координирует работу других, подчинённых ему узлов.

Копия (или второстепенный узел) данных или системы, которая синхронизируется с мастером для обеспечения отказоустойчивости или распределения нагрузки.

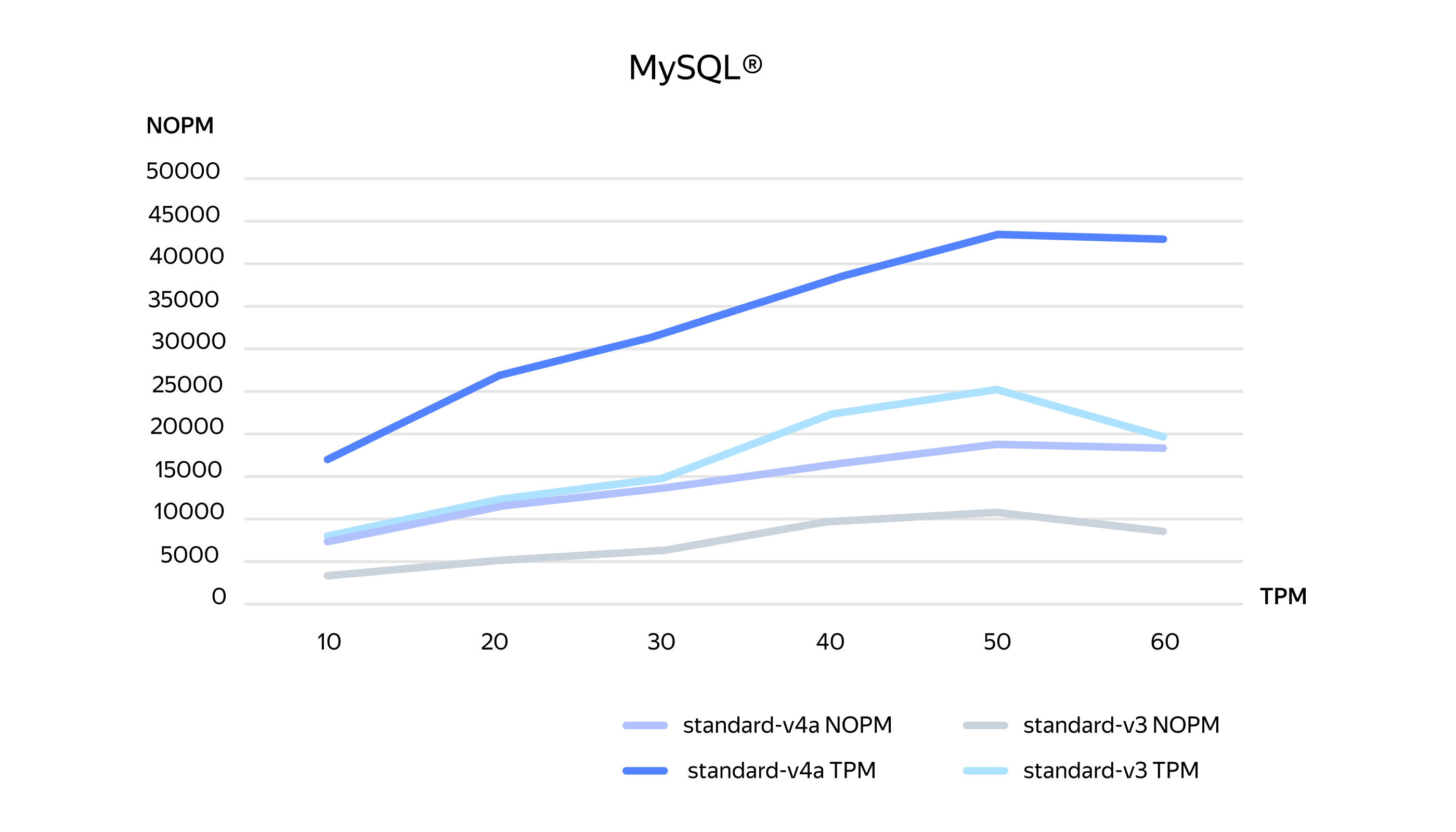

Конфигурация теста (бенчмарка TPC‑C), имитирующая операции только одного «склада», что приводит к высокой интенсивности запросов к одному и тому же набору данных.

Конфигурация теста (бенчмарка TPC‑C), имитирующая операции 100 «складов», что распределяет нагрузку по значительно большему объёму данных по сравнению с профилем с одним складом.

Конфигурации, которые мы использовали для каждого сервиса

|

Сервис

|

Версия

|

Профили vCPU/RAM (v3 vs v4a)

|

Диск

|

Топология

|

|

Yandex Managed Service for PostgreSQL

|

16

|

s3‑c4‑m16 vs s4a‑c4‑m16 (4 vCPU/16 ГБ)

|

network‑ssd 1000 ГБ

|

Мастер (D) + Реплика (A) / Одноузловой (D)

|

|

Yandex Managed Service for MySQL®

|

8

|

s3‑c4‑m16 vs s4a‑c4‑m16 (4 vCPU/16 ГБ)

|

network‑ssd 1000 ГБ

|

Мастер (D) + Реплика (A) / Одноузловой (D)

|

|

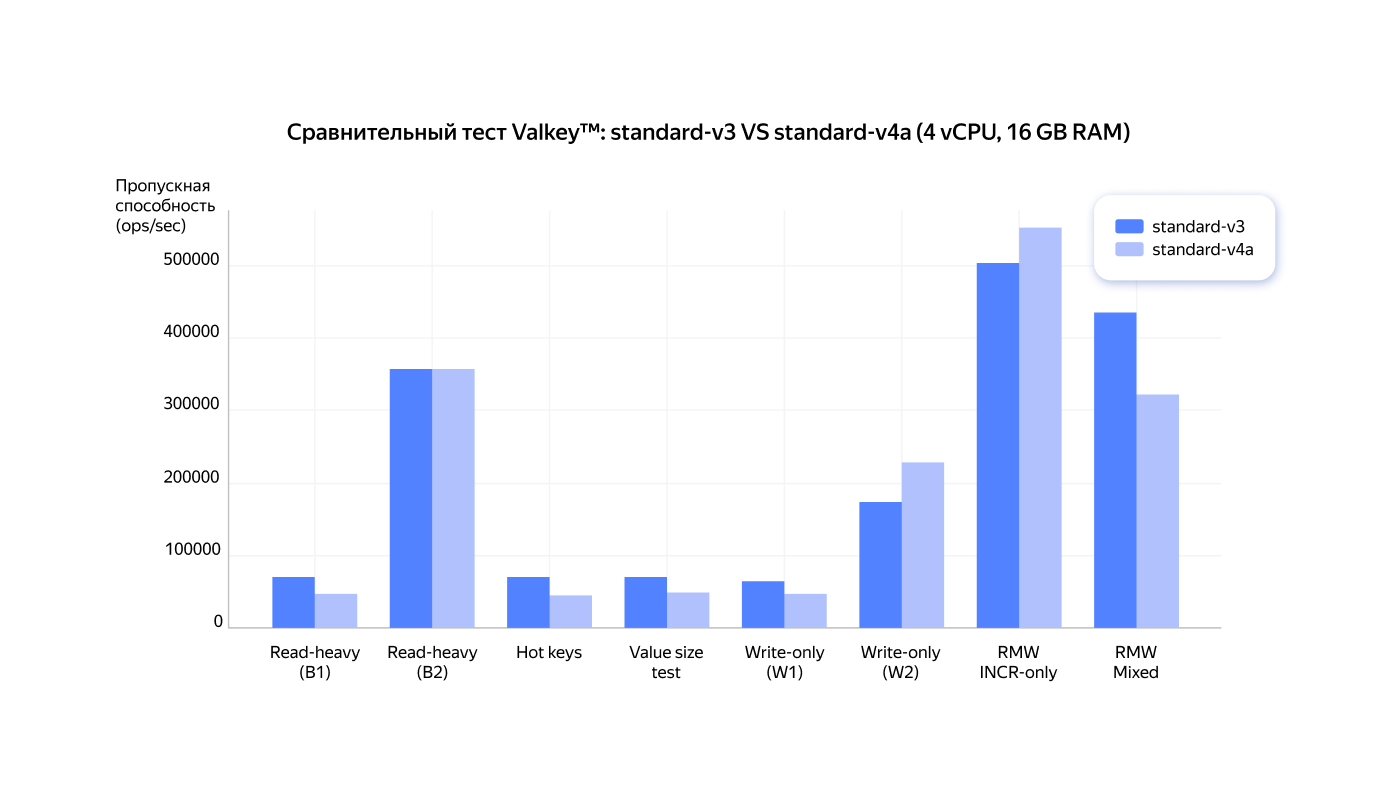

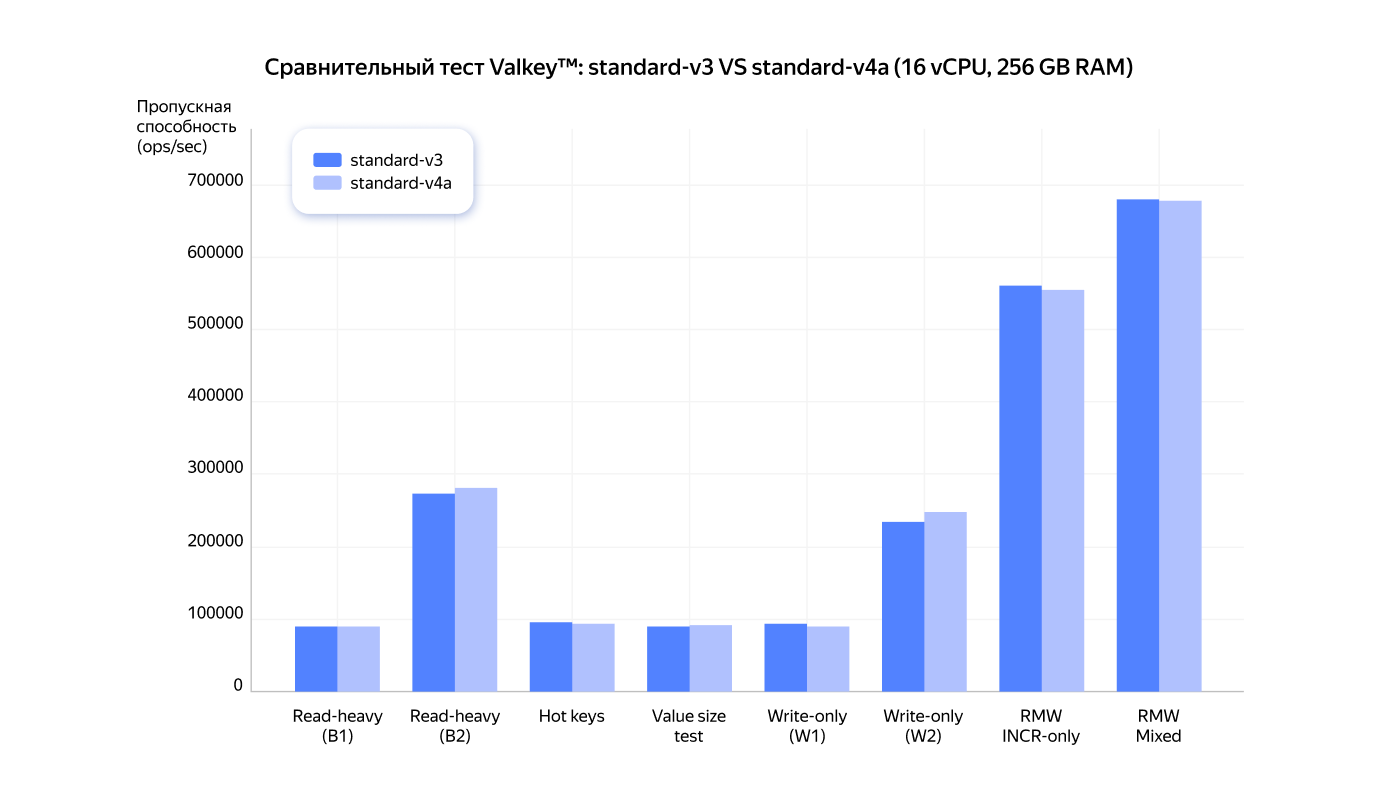

Yandex Managed Service for Valkey™

|

8.1

|

4 vCPU/16 ГБ vs 16 vCPU/256 ГБ

|

network‑ssd‑io‑m3 1023 ГБ

|

Single‑node (D)

|

|

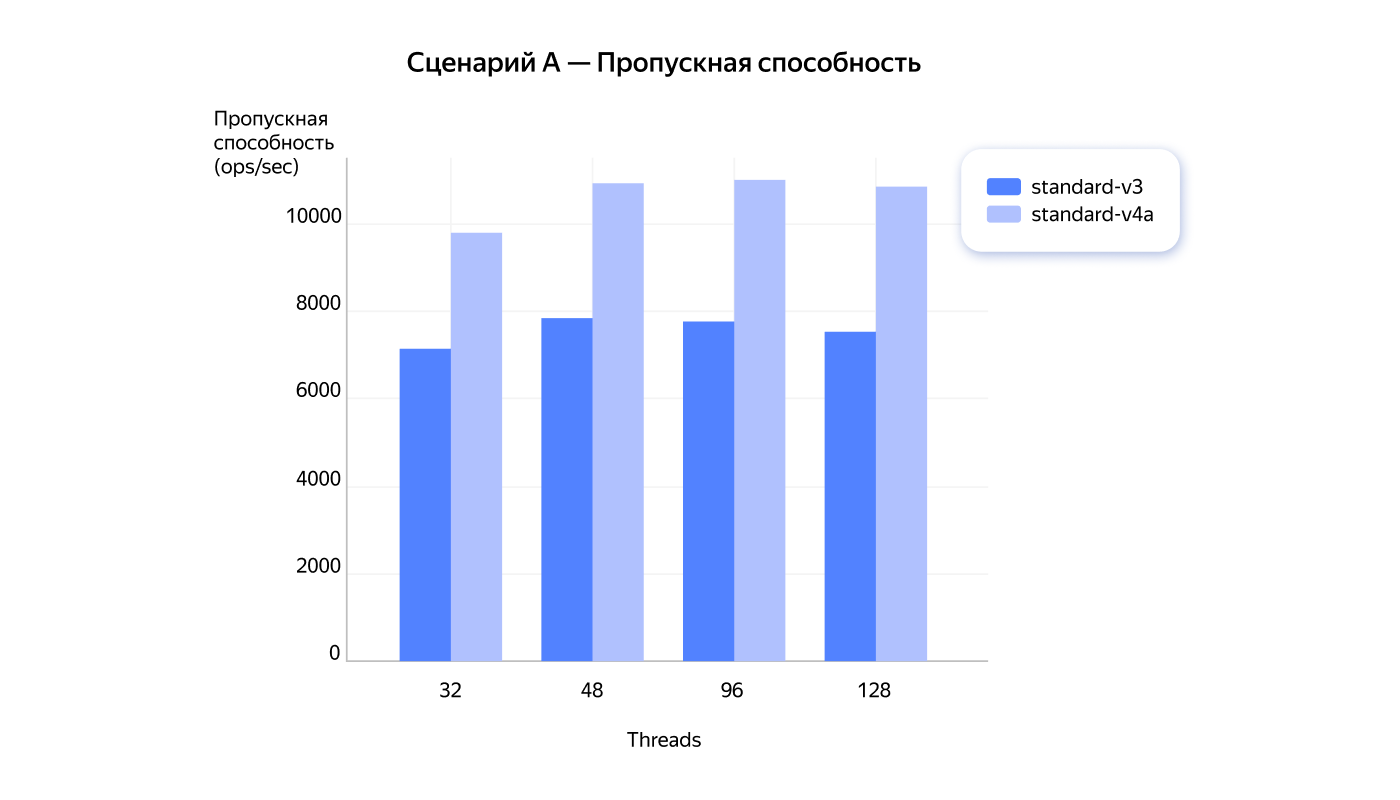

Yandex StoreDoc

|

8

|

4 vCPU/16 ГБ vs 16 vCPU/256 ГБ

|

network‑ssd‑io‑m3 1023 ГБ

|

Single‑node (D)

|

|

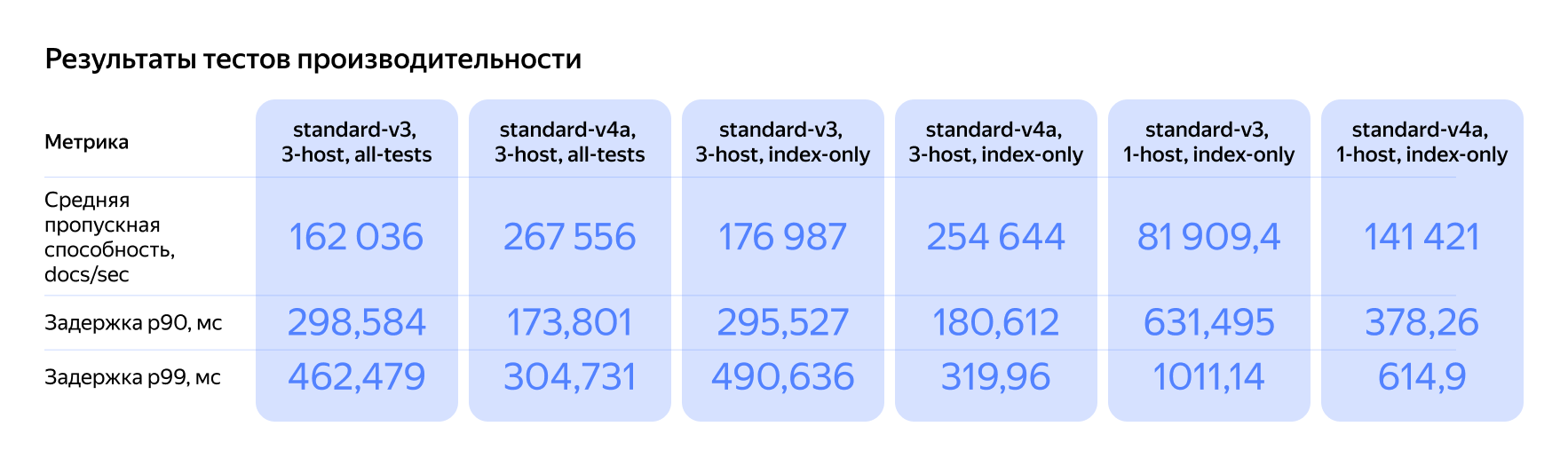

Yandex Managed Service for OpenSearch

|

—

|

Конфигурации s3/s4a c 4 vCPU/16 ГБ

|

network‑ssd‑io‑m3

|

1 и 3 узла (MASTER+DATA), набор http_logs

|

|

Yandex Managed Service for ClickHouse®

|

25.8

|

s3‑c8‑m32 (8 vCPU, 100% vCPU rate, 32 ГБ RAM)

|

network‑ssd 1 ТБ

|

1 однонодовый шард и 3‑нодовый отдельный ZooKeeper®

|

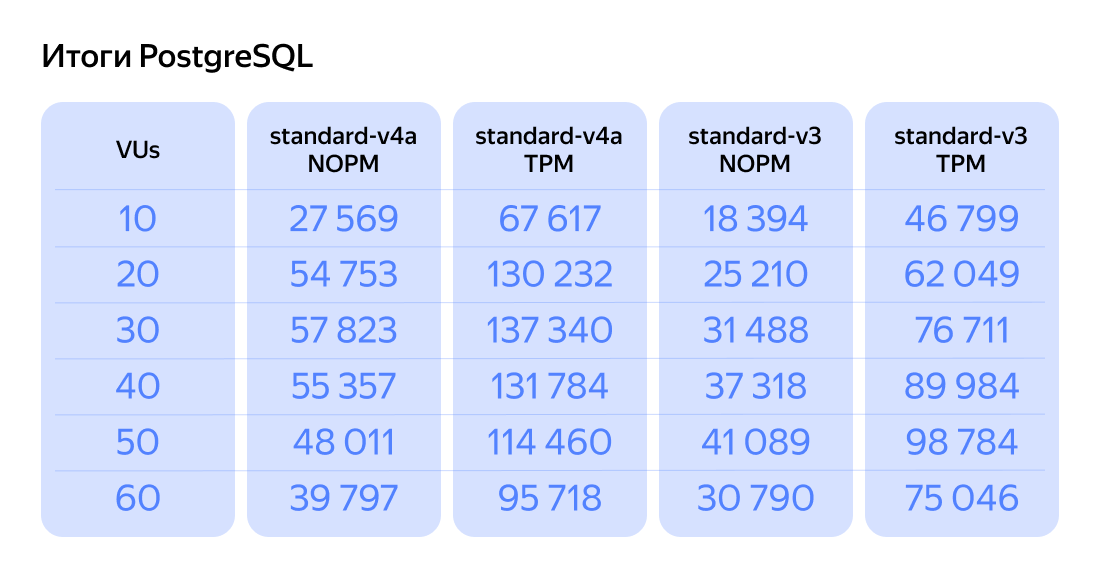

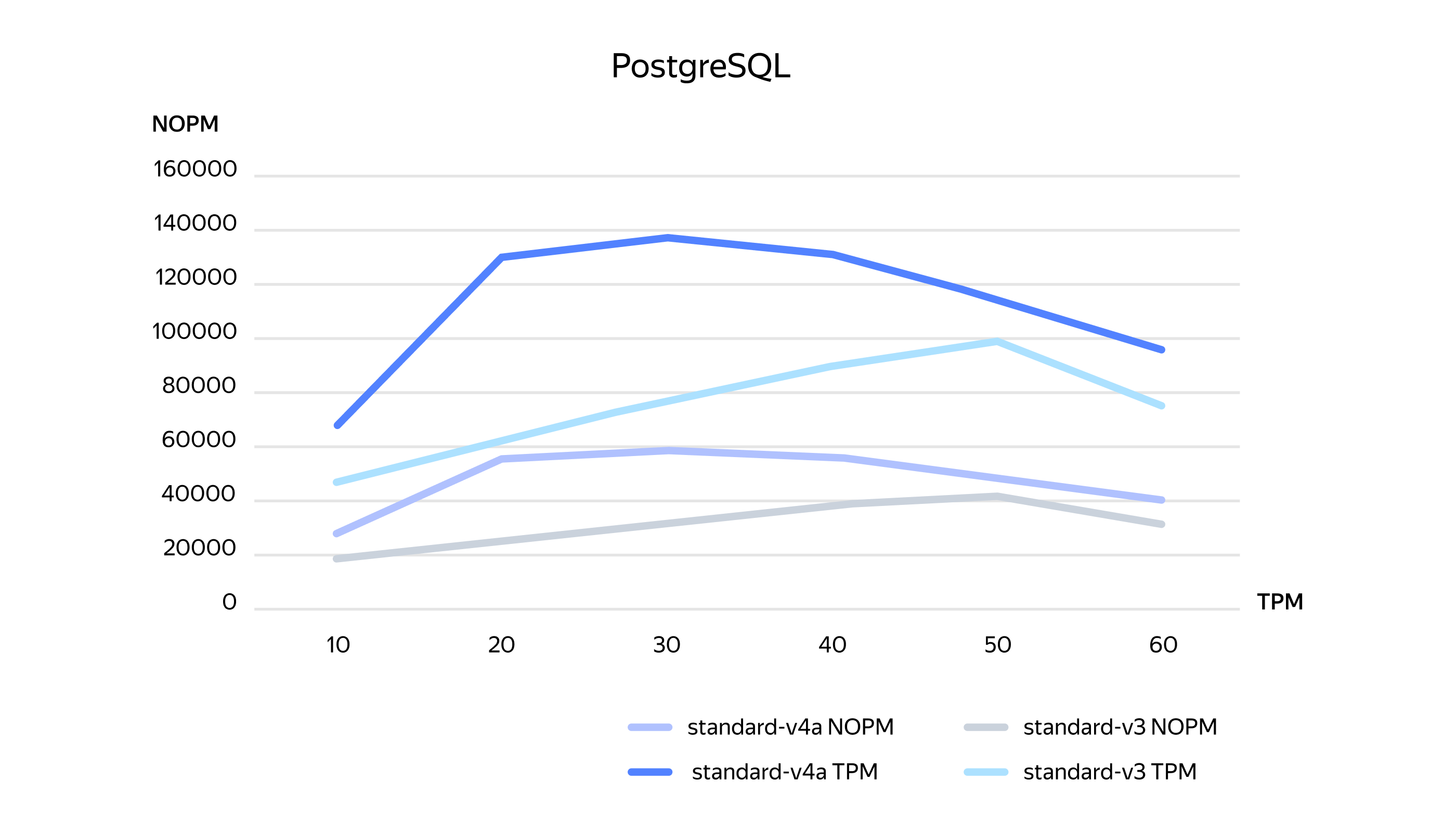

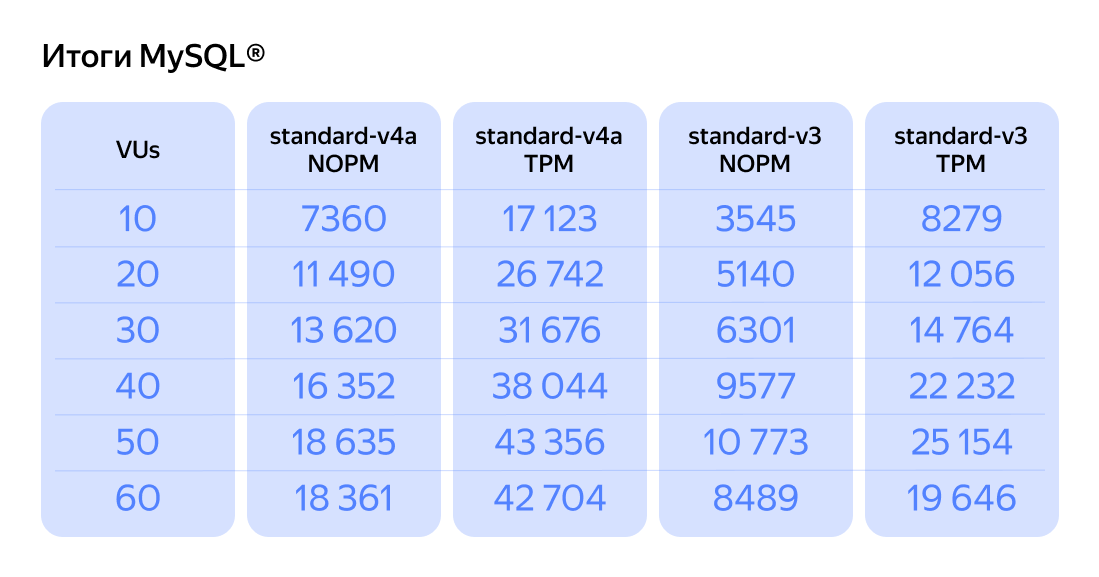

Стоит отметить важную деталь. В высокодоступной топологии, когда мастер находится в зоне D, а реплика в зоне A, разница в производительности CPU на коротких OLTP‑прогонах почти незаметна. Это происходит потому, что задержки на репликацию и передачу данных по межзонной сети «маскируют» реальные ограничения процессора.

Чтобы получить чистое сравнение производительности Compute, мы проводили дополнительные тесты. Для этого использовали одноузловые стенды или размещали мастер в той же зоне (D), где находился генератор нагрузки.

Ещё один нюанс касается выбора параметра warehouse в TPC‑C. Профиль с одним warehouse создаёт высокую нагрузку на одни и те же данные. Это провоцирует локальные конфликты, в основном блокировки строк. Профиль с сотней warehouses, напротив, распределяет нагрузку, что снижает «борьбу» за одни и те же ресурсы. Такой профиль позволяет лучше оценить «чистую» производительность CPU. Мы приводим оба результата, чтобы можно было сопоставить разные транзакционные паттерны с нашими стендами.